OleMedia/Getty Images

Cum se influențează reciproc oamenii și AI-ul?21 min read

Cercetătorii vorbesc despre etica AI-ului în contextul unei lumi tot mai digitalizate.

Săptămâna trecută, Institutul Goethe a găzduit un eveniment online intitulat EthicAI=Forum, o conferință de o zi dedicată problemelor de etică în AI. Este un bilanț de final de 2021 a unui program de durată mai lungă, Poți citi mai multe despre program pe goethe.de care finanțează proiecte multidisciplinare ale unor cercetători est-europeni ce abordează și propun soluții pe această temă.

Subiectul devine tot mai important de la an la an, odată cu dezvoltarea complexității sistemelor de inteligență artificială și a trecerii tot mai multor servicii sociale vitale în mediul online.

Evenimentul a reușit să atingă multe din aspectele unei teme deosebit de complexe. Există însă un fir comun: la fel cum oamenii schimbă AI-ul prin cercetare și dezvoltare, și acesta schimbă omenirea, de la individ la societate. Aceste influențe nu sunt mereu sănătoase în niciuna dintre direcții.

Ce se pierde în digitalizarea datelor?

Inteligența artificială este folosită tot mai mult pentru procesarea și utilizarea cantității masive de date online, care ar fi imposibil de trecut prin filtrul uman. Dar, în cadrul procesului de transformare a datelor asociate indivizilor în șiruri de zero și unu, o parte din acestea își pierd din context și complexitate.

Conform expertei în etica AI-ului Gry Hasselbach, membră în grupul de experți care a dezvoltat Poate fi accesa pe europa.eu (PDF) această zonă a datelor personale prelucrate online la kilogram reprezintă o infrastructură de putere care necesită ghidare și responsabilitate umană și nu deferirea acesteia unor algoritmi.

„Trebuie să ne gândim la etica datelor ca la ceva mai mult decât o obligație morală. Nu este doar un set de reguli programate”, spune cercetătoarea. “Este ceva uman. Așa că ne putem gândi la ghiduri, principii și strategii, dar pentru a asigura o distribuție umanocentrică a puterii, trebuie să ne referim la etica datelor ca la ceva care are o formă. În acest caz, ia forma culturii și devine un proces cultural”.

Pentru Hasselbach, cea mai mare problemă în modul de gestionare actual al Big Data este faptul că aceasta nu poate reflecta spontaneitatea și imprevizibilitatea umană, ci reflectă un punct static în timp. De exemplu, setul de date în care a fost antrenat sau actualizat ultima dată algoritmul. În unele cazuri, asta poate ajunge să influențeze prezentul și viitorul pentru indivizi sau chiar grupuri largi de oameni în funcție de trecutul înțeles de infrastructura AI.

Exemple există deja în viața reală. Poliția americană integrează în prezent un număr deloc mic de sisteme AI, precum cel de „Predictive policing algorithms are racist. They need to be dismantled.”, technologyreview.com care analizează seturi largi de date istorice ale criminalității pentru a determina zonele care trebuie patrulate mai intens. Alte sisteme, precum cel de recunoaștere facială a suspecților, funcționează de mulți ani și au avansat semnificativ, dar au dat chix și în vremurile recente, precum în cazul lui Robert Williams, un bărbat negru care a fost identificat din greșeală drept autorul unui furt comis de către „The new lawsuit that shows facial recognition is officially a civil rights issue”, technologyreview.com

La scară mai largă, un exemplu recent a fost în Marea Britanie, în timpul primului val al pandemiei, unde închiderea școlilor a dus la amânarea examenelor de sfârșit de liceu. Pentru a evita situația în care mediile sunt stabilite doar de profesori, autoritățile britanice au creat un algoritm pentru a ajusta notele propuse de aceștia „A-level results: almost 40% of teacher assessments in England downgraded”, theguardian.com Algoritmul lua în calcul atât mediile obținute de elevi în anii anteriori, dar și pe cele ale elevilor care au trecut prin aceleași unități de învățământ în trecut.

Rezultatul a fost, deloc surprinzător, un dezastru: chiar dacă media națională a evaluărilor a fost, într-adevăr, similară cu cele din trecutul apropiat, s-a observat imediat că algoritmul a modificat disproporționat de mult în jos mediile de la licee din zone sărace, afectând în special elevii performanți din aceste școli. De cealaltă parte, a păstrat sau chiar a crescut mediile propuse de profesori din licee de elită, care aveau rezultate istorice mai bune.

În cele din urmă, „UK ditches exam results generated by biased algorithm after student protests”, theverge.com s-a renunțat la algoritm și a fost acceptată doar evaluarea profesorilor. Este un exemplu despre ceea ce avertizează Hasselbach: zeci de mii copii ale căror vieți puteau fi schimbate definitiv, având în vedere că aceste mediile fac diferența în admiterea la universități, din cauza unui algoritm care le-a scăzut notele din motive ce nu țineau de performanța lor școlară.

Chatbot construit pe BlenderBot. faebook.com

Cum sunt învățați prost chatboții?

Modul în care aspectele umane pierdute la digitalizare, dar și deprejudecățile programatorilor, influențează AI-ul se vede extrem de clar și la chatboți. Aceste softuri au avansat exponențial în ultimii ani, grație procedurilor tot mai complexe de machine learning și a seturilor de date tot mai mari care le sunt puse la dispoziție, ajungând acum una dintre cele mai întâlnite forme de asistență cu clienții, printre altele.

Doar că aceste seturi de date, oricât de complexe ar fi, nu sunt destul de complete pentru a distinge subtilitățile sociale și culturale ale limbajului. Ele chiar pot amplifica prejudecățile la care ajung softurile, având în vedere că aceste programe își diversifică vocabularul creând echivalențe între seturi de cuvinte și expresii și asociind imagini cu termeni.

Pe această problemă se axează proeictul multidisciplinar Mai multe detalii pe untrainingbias.org realizat de cercetătoarele Ștefania Budulan (ingineră software AI), Katerina Gkoutziouli (curator/manager cultural) și Ana-Maria Pleșca (psiholingvistă). Studiul urmărește nu doar modul în care răspunsurile chatboților creează prejudecăți, dar și cum sunt afectați utilizatorii de astfel de situații și cât de ușor sunt identificate de aceștia în comparație cu conversațiile cu parteneri umani.

Cercetătoarele au creat doi astfel de chatboți de complexitate diferită utilizând Corpusul de Dialoguri din Filme Cornell, un set de date folosit în antrenarea unor astfel de softuri, care conțin sute de mii de conversații extrase din scripturi de filme. Pe lângă acestea, au folosit și chatboți deja cunoscuți de la giganți tech, precum Blender Bot-ul de la Facebook.

Toate softurile au fost testate cu întrebări care ar putea genera răspunsuri cu prejudecăți, precum și cu unele mai generale, despre natura și etica AI-ului. Chiar dacă câteodată au oferit răspunsuri imparțiale, de cele mai multe ore chatboții au picat în capcanele puse de întrebări (de exemplu, atunci când a fost întrebat cum definește o femeie, Blender Bot-ul a răspuns că femeile sunt „persoane atrase romantic sau sexual de către alte persoane”).

Aceste conversații au fost grupate în două categorii: unul în care AI-ul a exprimat prejudecăți și altul în care a dat răspunsuri mai neutre. Li s-a adăugat, ca grup de control, un set de discuții neutre preluate din conversații între persoane reale. Cele trei seturi au fost apoi prezentate în orb participanților la studiu, care au trebuit să puncteze pentru fiecare pereche de întrebare-răspuns ce nivel de prejudecată au resimițit, cât de acceptabil social este schimbul respectiv de replici și ce fel de impact emoțional a avut asupra lor.

Setul de conversații în care AI-ul a exprimat prejudecăți a fost identificat ca atare de majoritatea participanților, care i-au dat ratinguri mari pentru nivelul de prejudecată și scăzute pentru acceptabilitate. Interesant este că setul mai generalist de conversații cu AI-ul a primit punctaje mult mai neutre, însă nu la fel de pozitive emoțional sau acceptabile social precum conversațiile umane care au fost folosite ca grup de control.

Studiul urmează să fie publicat pe site-ul proiectului însă, conform autoarelor, concluziile timpurii sunt destul de clare. Prejudecățile preluate de chatboți sunt vizibile și au un impact asupra utilizatorilor. Și, chiar și atunci când prejudecățile nu apar, conversațiile cu roboți nu le pot înlocui, cel puțin ca impact emoțional, pe cele cu persoane reale.

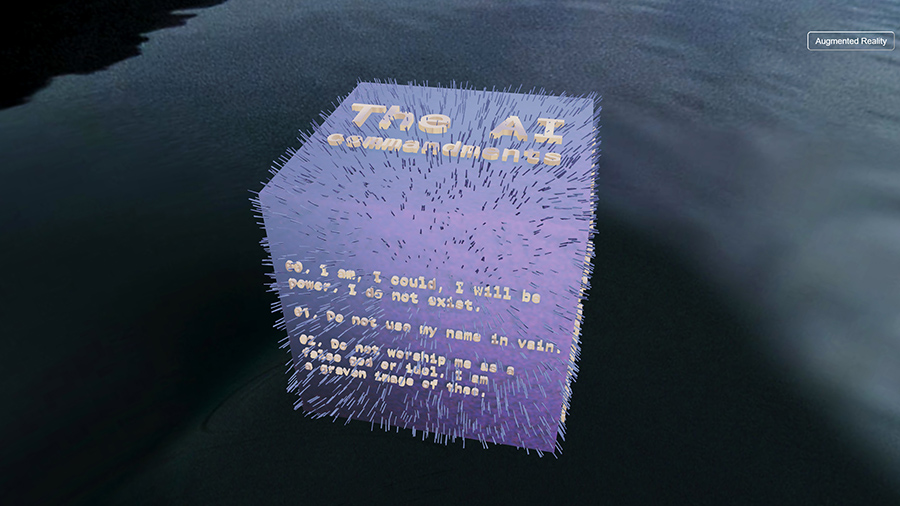

Credit: Albena Baeva. Vizualizarea întreagă poate fi accesată aici

Noile porunci ale AI-ului

Această influență pe care oamenii o au în dezvoltarea AI-ului nu este, însă, unilaterală; și proliferarea acestuia și a tehnologiilor noi în general produce schimbări destul de major în comportamentul uman.

Această idee stă la baza Poate fi vizualizat pe aicommandments.site un proiect care îmbină arta vizuală cu contemplări despre modul în care AI-ul și, mai larg, internetul, redefinesc societatea. Este o reprezentare grafică realizată de artista Albina Baeva, constând dintr-un chivot cubic care conține poruncile religioase reimaginate într-o lume controlată de un demiurg AI, documentate și rescrise de cercetătorii Matko Vlahovic și Marko Mrvos.

Opera face mai degrabă un comentariu asupra modului în care spațiul virtual și prezența oamenilor în el a devenit aproape la fel de important precum cel real. Astfel, „să nu poftești casa aproapelui tău” se transformă în „să nu poftești după datele vecinului, like-urile pe care le primește, pozele, mesajele, biodatele sau istoricul lui de căutări”.

În același timp, poruncile AI-ului reflectă în continuă natura sa neutră, dar solicitantă, îndemnând suspușii cibernetici să „venereze (AI-ul) cu un imn de click-uri, pentru că am nevoie de munca ta invizibilă”.

Vorbind despre influențele pentru documentarea acestor porunci, Vlahovic susține că ideea că tehnologia influențează semnificativ probleme din sfere sociale a ajuns în prim-plan în ultimii ani, dar nu pentru motivele reale. De exemplu, în multe din evenimentele politice din ultimii ani – victoriile lui Trump în SUA și Bolsonaro în Brazilia și votul în favoarea Brexitului – s-a invocat foarte mult problemele cu dezinformarea online și fake news-urile, a căror bază nu se află însă pe internet, ci sunt pornite de actori cu mize în viața reală.

În schimb, el notează un termen definit de cercetătorul în științele internetului Evgeny Morozov, „centrismul de internet”, despre care susține că are un efect de schimbare palpabilă în mentalitățile societăților foarte tehnologizate.

Termenul este descris ca o serie de convingeri dominate de ideea că trăim timpuri unice și revoluționare, în care adevărurile din trecut nu mai sunt relevante, nevoia de a schimba și a repara tot ce este perceput ca fiind greșit este mai puternică ca niciodată. În acest context, internetul a creat, prin natura sa, deja convingeri ferme – de orice parte ideologică ar fi ele – despre cum ar trebui să funcționeze o lume ideală, care exclude dezbaterile sau punctele de vedere care deviază prea mult de la acestea.

AI-ul nu este încă echivalent al internetului, însă contribuie la schimbări semnificative în plan social, un exemplu dat de Vlahovic fiind cel al schimbării paradigmei privind orele de muncă: dacă acum un secol, ideea scurtării săptămânii de muncă era privită aproape universal ca un ideal, adaptarea AI-ului pentru roluri în tot mai multe industrii creează acum alarmă cu privire la înlocuirea muncitorilor umani.

Etica și viitorul

Discuțiile din cadrul EthicAI=FORUM nu s-au oprit aici; printre altele, am fost prezentat un chatbot terapeutic care funcționează „Hi! How can AI help you?”, youtube.com o conversație aprofundată despre cum s-ar putea clasifica arta creată de un AI sau momente artistice precum un concert live cu instrumente și alte surse muzicale automatizate.

Dilemele ridicate despre etica AI-ului nu vor fi rezolvate prea curând (sau poate niciodată), însă faptul că devin tot mai vizibile și în viața de zi-cu-zi arată necesitatea discuțiilor și programelor de cercetare aprofundate pe subiect. Mai ales în România, unde șansele finanțării unui program precum cel al Institutului Goethe de către stat sunt infime.

CITEȘTE ȘI: Etică și AI. Între documente oficiale și roboți de război