akinbostanci/Getty Images

Algoritmul care transcrie precis înregistrările în română20 min read

Start-up-ul bucureștean Vatis Tech propune un algoritm de transcriere speech-to-text în limba română cu acuratețe ridicată

Dacă pentru limba engleză și alte limbi de circulație internațională există de ani buni programe de transcriere a înregistrărilor audio care funcționează bine , pentru limba română o astfel de soluție părea îndepărtată. La începutul pandemiei, o echipă de ingineri software din București a creat Detalii pe vatis.tech o companie care pe parcursul ultimilor doi ani a lucrat intens la crearea unui algoritm capabil să transcrie cât mai precis înregistrările audio sau video în limba română.

Rezultatul este o platformă destinată celor care au un volum mare de audio sau video ce trebuie transcris, dar și altor utilizatori, cu nevoi mai specifice, precum jurnaliști, creatori de conținut audio-video sau juriști. Vatis Tech oferă o perioadă de trial de zece ore. Ulterior utilizatorul poate plăti pe ora de înregistrare sau să-și facă un abonament lunar, dacă are foarte multe ore de transcris. În plus, alte programe pot integra algoritmul în serviciile proprii prin intermediul unui API.

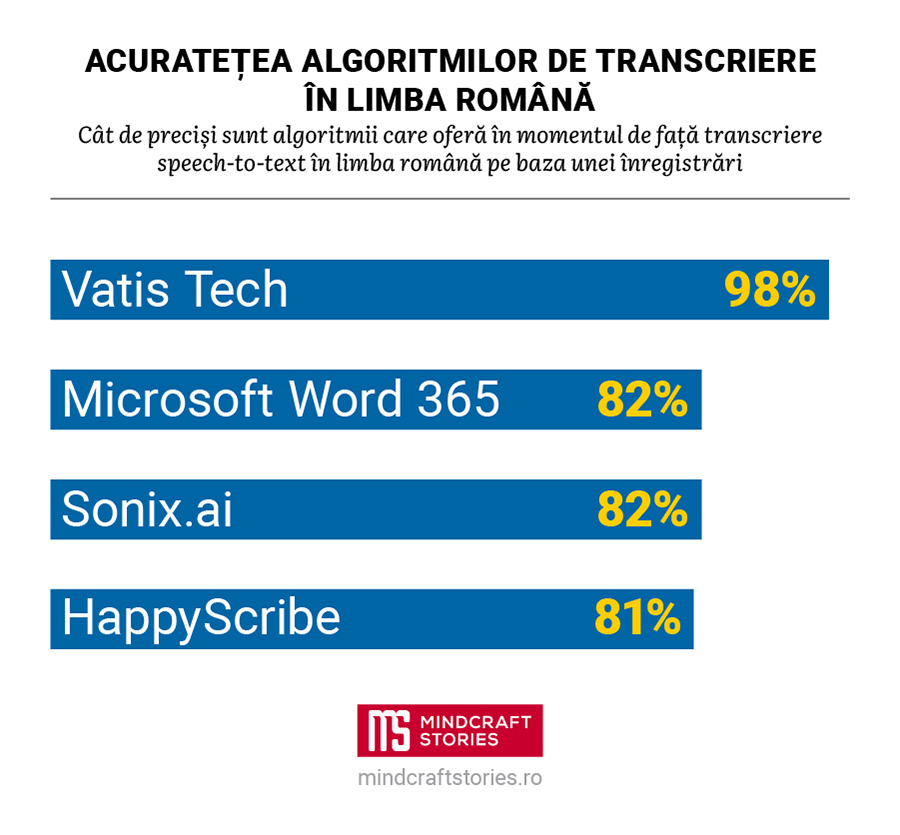

Am testat algoritmul oferit de start-up-ul bucureștean, dar și alte servicii care oferă transcriere în limba română pe baza unei înregistrări, folosind un scurt interviu înregistrat cu telefonul mobil. Precizia a fost calculată prin intermediul Mai multe detalii pe wikipedia.org o măsură folosită în informatică și lingvistică pentru a exprima numărul de editări de câte un singur caracter necesare pentru ca două texte să devină identice. Pentru fiecare caz în parte, comparația a fost făcută între transcrierea automatizată needitată și una făcută manual pentru a reprezenta cât mai exact ceea ce se aude pe înregistrare.

Soluția oferită de Vatis Tech a reușit să transcrie interviul cu acuratețe de 98%, în timp ce competitorii au atins 82% – ceea ce poate că sună decent, însă în realitate reprezintă o cantitate semnificativ mai mare de muncă de editare, pentru că înseamnă mai multe cuvinte absente sau transcrise greșit.

Alec Pop

În mare, rezultatele sunt similare cu cele pe care compania le susține public, anume de o acuratețe de 97% în transcriere, mai ridicată cu 15-20% față de cea a principalilor competitori.

Am vorbit cu Adrian Ispas, CEO și co-fondator Vatis Tech, despre cum a început proiectul, cum poate fi antrenat un algoritm speech-to-text pe limba română și ce îmbunătățiri sunt plănuite pentru serviciu în viitorul apropiat.

Mindcraft Stories: Cum ați început Vatis Tech și ce v-a determinat să creați o soluție de transcriere pentru limba română?

Adrian Ispas: Ideea a început în martie 2020. Noi voiam să căutăm în podcasturi de limba română, să facem un fel de motor de căutare pentru audio. La momentul respectiv, n-am găsit un algoritm de speech recognition fezabil pe limba română, în sensul că acuratețea celor existente era destul de scăzută.

Am dezvoltat prima dată platforma pe partea de Business-to-Consumer, tipul de afaceri în care produsele și serviciile sunt comercializate direct către utilizatorul final în sensul că se adresa podcasterilor, jurnaliștilor și putea fi privită ca un fel de Google Drive pentru audio. Scopul era să indexeze conținut, să îl sumarizeze, să extragă diverse insight-uri din el. Dar lipsa unei tehnologii de speech recognition de înaltă acuratețe a afectat absolut toate celelalte funcționalități.

Și testerii ne-au zis că lipsa acurateței le îngreunează munca, într-un fel, pentru că e posibil să fie mai rapidă transcrierea manuală. Neexistând vreo soluție mai bună, ne-am decis să construim noi tehnologia asta.

Evident, au fost mulți oameni care ne-au zis: „Dacă n-a reușit Google să facă asta, atunci cum ați reuși voi?” Dar uite că după un an și jumătate am reușit să construim tehnologia și în momentul de față e cam cea mai bună din punctul de vedere al acurateței pe limba română.

M.S:: Ce acuratețe are softul vostru și cum se compară cu competitorii?

A.I.: Noi scoatem în medie o acuratețe de 97%, iar competitorul nostru principal din zona de Big Tech, Google, scoate 79%. Acuratețea se calculează în în felul următor: sunt niște seturi de date – noi avem în total vreo 30 și ceva de seturi de date din diverse topicuri, domenii și așa mai departe – care sunt pur și simplu date audio cu etichete text generate de oameni, pe care algoritmul nostru sau orice alt algoritm nu le-a văzut vreodată. Adică sunt date transcrise de algoritm la prima vedere. Se compară rezultatul transcriptului generat automat cu eticheta de transcript făcută de fapt manual de oameni, și se calculează o distanță – în linii mari, este distanța Levenshtein între transcriptul generat de algoritm și cel făcut manual.

Conform acestui procedeu, care este standard în industria de speech recognition, ajungem la acest procent de 97 %.

M.S: Au fost greu de găsit sau de alcătuit acele dateset-uri pe limba română?

A.I.: A fost un proces destul de anevoios pentru că, în momentul în care noi ne-am apucat de treabă, pentru limba română nu prea existau date (și nici acum nu prea sunt). Principala noastră problemă, când ne-am apucat de aplicație, era că nu aveam date și n-aveam nicio platformă de etichetare a datelor. Ce am făcut să construim această platformă, să căutăm oamenii care să ne ajute cu etichetarea datelor și să facem rost de date. Totul a fost construit de noi și a fost un proces care ne-a luat cam șase luni – am început undeva în la început de noiembrie 2020 și în aprilie 2021 am avut prima versiune a softului.

M.S: Softul funcționează pe un algoritm de machine learning când este hrănit cu astfel de date?

A.I.: Exact, adică tehnologia din spate este o tehnologie de machine learning, deep learning mai exact, iar algoritmul nostru este compus din două layere foarte mari.

Primul este numit layer self-supervised, în care intră cantități mari de date audio neetichetate, de ordinul miilor sau zecilor de mii de ore audio. Scopul acestui layer este să facă algoritmul să înțeleagă cum sună limba vizată.

Al doilea layer este compus din date etichetate și este mai mic, undeva la câteva sute de ore de audio. Ele duc algoritmul înspre a învăța cum se scrie limba respectivă, după ce a învățat în prima fază cum se aude. Aceste două faze de antrenare oferă robustețe modelului și pot duce la rezultate foarte precise.

M.S: Întâmpină tehnologia voastră probleme cu diacriticele sau cu diferitele accente care există în regiunile din România?

A.I:.Soluția noastră este învățată din start să scrie cu diacritice, deci nu sunt probleme pe partea asta. În schimb, la accente și dialecte pot apărea într-adevăr limitări ale tehnologiei, dar sunt limitări pe care le adresăm în momentul de față.

Am început un parteneriat cu o companie care ne poate furniza date pe diferite zone geografice din România, cu limbaje și accente diferite, și antrenăm modelul pe acele date. Este un proces de învățare continuă, care poate fi aplicat și pe domenii profesionale specializate, de exemplu limbajul medical sau limbajul legal.

Noi am antrenat deja algoritmul pe partea de apeluri telefonice și pe zona legală, unde am reușit să obținem acuratețe cu între 20 și 40% mai bună (n.r. – pentru astfel de înregistrări) față de modelul de bază. Deci este o problemă rezolvabilă și știm cum să o adresăm, iar asta se poate face inclusiv cu datele specifice clienților. Dacă clienții au cerințe foarte particulare și ne oferă date relevante, noi putem să îmbunătățim tehnologia fix pe acel set de date.

Co-fondatorii Vatis Tech, de la stânga la dreapta: Alexandru Țopală, Adrian Ispas și Emanuel Nazare. FOTO: Vatis Tech

M.S: Ce domenii particulare de limbaj acoperiți în prezent?

A.I.: În momentul de față, avem modele pentru zona de apeluri telefonice, cât și pe zona de limbaj legal, așa cum este folosit în tribunalele din România. Urmează să pornim un parteneriat pentru crearea unui model de limbaj medical, unde tehnologia noastră să fie folosită de doctori în momentul în care aceștia fac partea de interpretare, de obicei prin completarea unor rapoarte manuale sau prin dictarea lor asistenților – acum ar putea să le transcrie automat.

M.S:: La ce alte de funcționalități lucrați în continuare?

A.I.: În momentul de față avem speech-to-text și lucrăm la mai multe funcționalități.

Vrem să perfectăm modelele cu limbaj specializat, dar și traducerea pe alte limbi europene. Avem acum șapte feature-uri pe care vrem să le implementăm în viitorul apropiat, cum ar fi un search global, prin care să poți căuta automat cuvinte-cheie în toate transcripturile pe care le-ai făcut în platforma noastră, ceea ce îți deschide un orizont foarte mare dacă trebuie să cauți în mii de ore sau zeci de mii de ore de audio. Plănuim și diverse feature-uri pe partea de interfață și user management, de exemplu să vezi pe fiecare utilizator cât și ce a consumat sau în ce zile se consumă mai mai mult pe abonamentul tău.

Pregătim și un update pe partea de infrastructură on-premise, pregătim suport pentru mai multe protocoale, mai multe SDK-uri și mai multe limbaje de programare. Avem în lucru și o interfață pentru zona de testing, sunt câteva lucruri specializate domeniului care o să-i ajute pe testeri să folosească tehnologia asta foarte ușor.

M.S: Poți să-mi spui cam care sunt cele mai mari dificultăți cu care se confruntă în general soft-urile the voice recognition? Ce le oprește din a atinge pasul următor de acuratețe?

A.I.: Pe de o parte, este fix partea asta de calitate audio, dar pe de alta este și partea de acces la date. Fiind algoritmi de machine learning, astfel de softuri sunt proiectate să lucreze cu cantități foarte, foarte mari de date și dacă nu ai date pe limba respectivă sau ele sunt limitate, precum pe limba română sau multe alte limbi din zona Europei Central și de Est, automat algoritmul nu are din ce să învețe, nu are suficient de multe exemple.

M.S: Care sunt cele mai mari dificultăți pe care le întâmpină tehnologia voastră?

A.I.: Sunt două lucruri care influența calitatea transcrierii în momentul de față, și ele sunt de fapt limitări tehnologice, care pot fi rezolvate în timp.

Prima problemă este dacă speakerii încep să vorbească unul peste altul. Nici noi, ca oameni, nu putem înțelege foarte clar în momentul în care vorbesc doi oameni în paralel, asta e o parte a limitării tehnologiei.

A doua ține de calitatea audio. De exemplu, dacă speakerul e foarte îndepărtat de microfon sau există foarte, foarte mult zgomot de fundal. Din nou, dacă devine destul de greu de înțeles pentru un om ce e acolo, automat și tehnologia va avea anumite dificultăți în crearea unui transcript cât mai precis. Sunt probleme rezolvabile, dar mai avem până să ajungem la un model care să fie complet agnostic față de mediul unei înregistrări audio.